Cloud Storage cho AI: Các lựa chọn và ưu, nhược điểm

Chúng ta sẽ cùng xem xét lưu trữ trên cloud so với on-premise cho khối lượng công việc AI, lý do vì sao cloud đôi khi là lựa chọn tối ưu, cùng các công nghệ đang thúc đẩy tốc độ AI trên đám mây như xử lý song song và GPUDirect.

GPUDirect là một tập hợp các công nghệ của NVIDIA cho phép các thiết bị phần cứng, bao gồm cả GPU, truy cập trực tiếp vào bộ nhớ của nhau hoặc bộ nhớ hệ thống mà không cần CPU can thiệp, giúp tăng tốc độ truyền dữ liệu và giảm tải cho CPU.

Các kiến trúc sư hệ thống CNTT khi thiết kế hệ thống lưu trữ dành cho trí tuệ nhân tạo (AI) cần cân bằng giữa dung lượng, hiệu suất và chi phí.

Các hệ thống AI - đặc biệt là những hệ thống dựa trên mô hình ngôn ngữ lớn (LLM) - tiêu thụ khối lượng dữ liệu khổng lồ. Trên thực tế, các mô hình LLM hay Generative AI (GenAI) hoạt động hiệu quả hơn khi được cung cấp càng nhiều dữ liệu càng tốt. Giai đoạn huấn luyện (training) trong AI đặc biệt đòi hỏi lượng dữ liệu cực lớn.

Ngược lại, giai đoạn suy luận (inference) của AI lại cần hiệu suất cao để tránh tình trạng hệ thống phản hồi chậm hoặc không thể hoạt động. Giai đoạn này yêu cầu thông lượng lớn và độ trễ thấp.

Do đó, một câu hỏi then chốt được đặt ra là: chúng ta có thể sử dụng kết hợp lưu trữ tại chỗ (on-premise) và cloud ở mức độ nào? Lưu trữ tại chỗ mang lại hiệu suất cao hơn và mức độ bảo mật tốt hơn. Trong khi đó, lưu trữ đám mây lại có khả năng mở rộng tốt, chi phí thấp hơn, và tiềm năng tích hợp thuận tiện hơn với các mô hình AI hoặc nguồn dữ liệu đã nằm sẵn trên cloud.

Trong bài viết này, chúng ta sẽ xem xét ưu – nhược điểm của từng hình thức lưu trữ và cách tối ưu hóa chúng cho các ứng dụng AI.

Lưu trữ cho AI: On-premise hay cloud?

Các doanh nghiệp thường ưu tiên lưu trữ on-premise để đạt được tốc độ, hiệu suất và bảo mật tối đa — và các workload AI cũng không phải ngoại lệ. Lưu trữ cục bộ còn dễ dàng được tinh chỉnh để phù hợp với các nhu cầu cụ thể của mô hình AI, đồng thời ít gặp vấn đề nghẽn mạng hơn.

Bên cạnh đó, việc giữ các mô hình AI gần với nguồn dữ liệu cũng mang lại lợi ích rõ rệt. Trong môi trường doanh nghiệp, dữ liệu nguồn này thường là các cơ sở dữ liệu quan hệ chạy trên hệ thống lưu trữ dạng block.

Vì vậy, các nhà thiết kế hệ thống cần tính đến ảnh hưởng của AI tới hiệu suất của các hệ thống dữ liệu cốt lõi (system of record). Doanh nghiệp chắc chắn không muốn các ứng dụng quan trọng như ERP hay CRM bị chậm lại chỉ vì chúng đang cung cấp dữ liệu cho hệ thống AI. Ngoài ra, còn có những lý do rất rõ ràng liên quan đến bảo mật, quyền riêng tư và tuân thủ quy định khiến doanh nghiệp muốn giữ dữ liệu cốt lõi tại chỗ thay vì chuyển lên cloud.

Tuy nhiên, lưu trữ đám mây cũng mang lại những lợi ích đáng kể cho các dự án AI. Cloud dễ dàng mở rộng và người dùng chỉ phải trả cho những gì mình sử dụng. Trong một số trường hợp, dữ liệu nguồn cho AI vốn đã được lưu trữ sẵn trên cloud, ví dụ như trong các data lake hay ứng dụng SaaS.

Hệ thống lưu trữ cloud phần lớn được xây dựng dựa trên object storage, vốn rất phù hợp với dữ liệu phi cấu trúc – dạng dữ liệu chiếm phần lớn thông tin được các mô hình LLM tiêu thụ.

Song song đó, việc ngày càng có nhiều hệ thống lưu trữ hỗ trợ object storage on-premise cũng giúp các doanh nghiệp có thể thiết lập một lớp lưu trữ thống nhất – thậm chí là một không gian tên toàn cục (global namespace) – phục vụ cả hạ tầng tại chỗ lẫn đám mây, bao gồm các ứng dụng AI. Điều này đặc biệt quan trọng với những tổ chức có nhu cầu chuyển đổi linh hoạt giữa cloud và on-premise, hoặc vận hành hệ thống theo mô hình hybrid.

Lưu trữ AI và các lựa chọn trên cloud

Lưu trữ đám mây thường là lựa chọn hàng đầu của các doanh nghiệp khi bắt đầu các dự án thử nghiệm (proof-of-concept – PoC) cho AI. Điều này giúp loại bỏ nhu cầu đầu tư vốn ban đầu và có thể dễ dàng hủy bỏ sau khi kết thúc dự án.

Trong các trường hợp khác, doanh nghiệp xây dựng hệ thống AI theo mô hình “burst” từ trung tâm dữ liệu lên cloud – tức là sử dụng tài nguyên đám mây công cộng cho tính toán và lưu trữ nhằm đáp ứng các đợt tăng tải đột biến. Cách tiếp cận này phát huy hiệu quả cao nhất với các dự án AI có chu kỳ hoạt động cao ngắn hạn, ví dụ như các hoạt động theo mùa.

Tuy nhiên, sự xuất hiện của Generative AI dựa trên các mô hình ngôn ngữ lớn (LLM) đã khiến cán cân nghiêng mạnh về phía cloud, chủ yếu do khối lượng dữ liệu khổng lồ mà những mô hình này đòi hỏi.

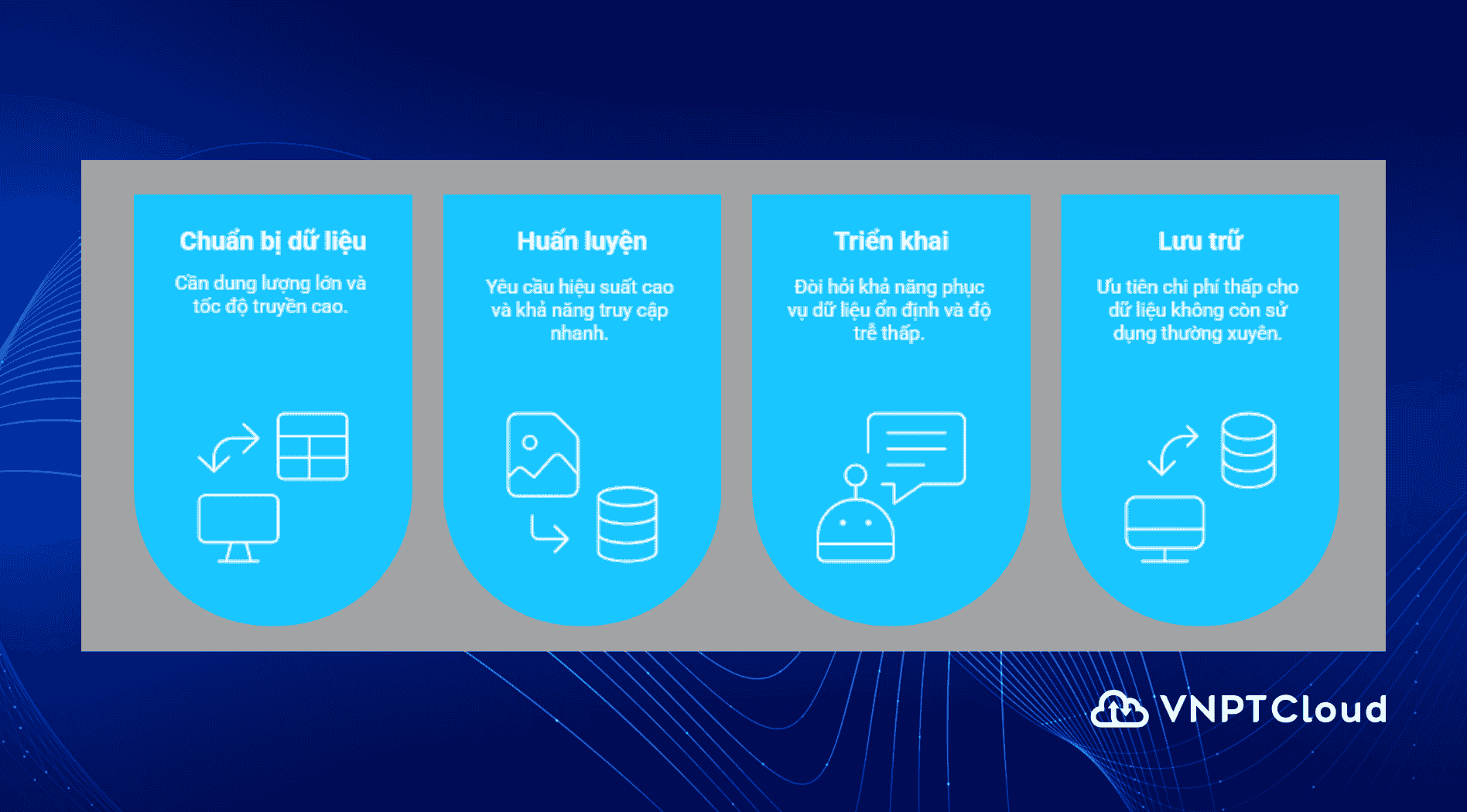

Cùng lúc đó, các nhà cung cấp dịch vụ cloud (hyperscaler) hiện đã cung cấp nhiều lựa chọn lưu trữ chuyên biệt cho các workload AI. Điều này bao gồm các dịch vụ lưu trữ được thiết kế riêng cho từng giai đoạn trong quy trình AI, cụ thể: chuẩn bị, huấn luyện, triển khai và lưu trữ (archive).

Theo các kỹ sư Google:

“Mỗi giai đoạn trong vòng đời học máy (machine learning lifecycle) có những yêu cầu lưu trữ khác nhau. Ví dụ, khi tải lên bộ dữ liệu huấn luyện, bạn có thể ưu tiên dung lượng lưu trữ lớn và tốc độ truyền cao. Tương tự, các giai đoạn huấn luyện, tinh chỉnh, triển khai và lưu trữ đều có các yêu cầu riêng biệt.”

Mặc dù phát biểu này áp dụng cho Google Cloud Platform, nguyên tắc tương tự cũng đúng với Microsoft Azure, Amazon Web Services, cũng như các nhà cung cấp khác như IBM, VNPT Cloud và Oracle. Tất cả đều cung cấp các dịch vụ lưu trữ cloud phù hợp với nhu cầu lưu trữ khối lượng lớn dữ liệu AI. Trong phần lớn trường hợp, dữ liệu phi cấu trúc được sử dụng bởi AI – bao gồm dữ liệu nguồn và dữ liệu huấn luyện – sẽ được lưu trữ dưới dạng object storage.

Chẳng hạn, các tùy chọn phổ biến là:

- AWS S3,

- Azure Blob Storage,

- Google Cloud Storage.

- VNPT Cloud Storage

Ngoài ra, các nền tảng phần mềm bên thứ ba như NetApp ONTAP cũng được cung cấp bởi các hyperscaler, giúp cải thiện khả năng di chuyển dữ liệu giữa cloud và môi trường on-premise.

Đối với giai đoạn sản xuất hay suy luận (inference) của hệ thống AI, việc lựa chọn lưu trữ còn phức tạp hơn nhiều. Các kiến trúc sư CNTT có thể chỉ định lưu trữ NVMe hoặc SSD với các cấp hiệu suất khác nhau cho từng phần quan trọng của quy trình AI. Lưu trữ truyền thống sử dụng ổ đĩa quay (spinning disk) vẫn phù hợp với các tác vụ như ingest dữ liệu ban đầu, xử lý sơ bộ, hoặc lưu trữ kết quả đầu ra.

Các loại lưu trữ này có thể được cấu hình theo cách trung lập về ứng dụng: kỹ sư có thể chỉ định các thông số hiệu suất và ngân sách tương tự như với bất kỳ workload nào khác. Tuy nhiên, một thế hệ mới của hệ thống lưu trữ cloud hiện đang được thiết kế từ đầu để phục vụ chuyên biệt cho AI.

Lưu trữ đám mây tiên tiến cho AI

Những yêu cầu đặc thù của hệ thống AI đã thúc đẩy các nhà cung cấp lưu trữ thiết kế hạ tầng chuyên dụng, nhằm loại bỏ các điểm nghẽn có thể xảy ra trong quy trình làm việc AI – cả ở môi trường on-premise lẫn cloud. Hai hướng tiếp cận quan trọng nhất trong số này là: xử lý song song (parallelism) và truy cập bộ nhớ GPU trực tiếp (direct GPU memory access).

Xử lý song song cho phép hệ thống lưu trữ xử lý đồng thời nhiều yêu cầu dữ liệu, đặc biệt hữu ích với khối lượng công việc đặc trưng của AI và học máy (ML). Nhà cung cấp Cloudian mô tả rằng, phương pháp này giúp tăng tốc quá trình huấn luyện và suy luận mô hình bằng cách cho phép hệ thống lưu trữ xử lý nhiều luồng dữ liệu song song.

Một ví dụ tiêu biểu là Google Parallelstore, ra mắt vào năm ngoái, cung cấp dịch vụ lưu trữ file song song được quản lý, hướng tới các ứng dụng AI yêu cầu input/output cường độ cao.

Trong khi đó, truy cập trực tiếp bộ nhớ GPU nhằm giải quyết vấn đề nghẽn cổ chai giữa bộ nhớ cache lưu trữ và GPU – vốn là thành phần đắt đỏ và khan hiếm. Theo ông John Woolley, Giám đốc thương mại tại Insurgo Media, hệ thống lưu trữ cần đảm bảo tốc độ truyền tải liên tục ít nhất 10GBps để tránh tình trạng “GPU bị đói tài nguyên”.

Giao thức GPUDirect, do Nvidia phát triển, cho phép GPU truy cập trực tiếp vào bộ nhớ ổ NVMe – tương tự như cách RDMA cho phép các hệ thống giao tiếp mà không cần qua CPU hoặc hệ điều hành. Giao thức này còn được gọi là Direct GPU Support (DGS).

Các lớp cache cục bộ giữa GPU và bộ lưu trữ chia sẻ có thể sử dụng block storage trên ổ NVMe SSD nhằm bão hòa băng thông cho mỗi GPU, với tốc độ lên tới 60GBps hoặc cao hơn. Kết quả là, nhiều nhà cung cấp dịch vụ cloud hiện đang lên kế hoạch triển khai thế hệ SSD mới, được tối ưu cho DGS và nhiều khả năng sẽ dựa trên SLC NAND.

“Khối lượng công việc inference đòi hỏi sự kết hợp giữa lưu trữ khối truyền thống và lưu trữ tối ưu hóa cho AI (DGS),” – ông Sebastien Jean, Giám đốc công nghệ tại Phison US (nhà sản xuất NAND), nhận định. “Workload định hướng GPU mới yêu cầu khả năng truy cập I/O cực nhỏ và độ trễ cực thấp.”

Vì thế, thị trường nhiều khả năng sẽ chứng kiến sự xuất hiện của các hệ thống lưu trữ chuyên dụng cho AI, bao gồm cả những sản phẩm đạt chứng nhận Nvidia DGX BasePod và SuperPod, cùng khả năng tích hợp AI mạnh mẽ.

Một số lựa chọn nổi bật gồm:

- Nutanix Enterprise AI

- Evergreen One for AI của Pure Storage

- Dell PowerScale

- Vast Data Platform của Vast

- Weka – nhà cung cấp NAS hybrid cloud

- Và các giải pháp từ HPE, Hitachi Vantara, IBM và NetApp.

Hiện tại, VNPT Cloud đang là đối tác chiến lược cung cấp các giải pháp lưu trữ của Nutanix, Dell, HPE, IBM, NetApp, ...

Tổng kết: Chìa khóa tối ưu lưu trữ cho AI nằm ở chiến lược kết hợp

Trong kỷ nguyên của AI và đặc biệt là Generative AI (GenAI), việc lựa chọn kiến trúc lưu trữ phù hợp không chỉ là vấn đề chi phí hay hiệu suất, mà là yếu tố sống còn để đảm bảo khả năng mở rộng, tốc độ xử lý và độ linh hoạt của hệ thống. Khi AI cần dữ liệu để học, thì cách lưu trữ dữ liệu cũng cần "thông minh" hơn.

Kết hợp giữa on-premise và cloud storage, sử dụng object storage cho dữ liệu phi cấu trúc, triển khai GPUDirect, parallelism, cùng lựa chọn đúng lớp lưu trữ theo từng giai đoạn của vòng đời AI (chuẩn bị – huấn luyện – suy luận – lưu trữ), sẽ mang lại hiệu quả cao nhất cả về hiệu suất lẫn tối ưu chi phí.

Tối ưu lưu trữ AI với VNPT Cloud Object Storage

👉 VNPT Cloud Object Storage là lựa chọn lý tưởng:

- Tương thích S3 API, dễ tích hợp với các nền tảng AI cloud-native.

- Quy mô mở rộng linh hoạt, từ vài GB đến hàng PB.

- Độ bền dữ liệu cao, phù hợp huấn luyện và lưu trữ đầu ra GenAI.

- Dễ dàng kết nối với các dịch vụ AI, GPU, ... trong hệ sinh thái VNPT Cloud.

📌 Liên hệ tìm hiểu thêm về giải pháp Object Storage dành cho AI workloads tại VNPT Cloud, hoặc liên hệ đội ngũ chuyên gia để được tư vấn triển khai phù hợp với nhu cầu doanh nghiệp bạn.